Einführung

Haben Sie sich jemals gefragt, wie Sprachmodelle wie ChatGPT die Ähnlichkeit zwischen Wörtern erkennen, sodass sie verstehen, dass 'Katze' und 'Hund' verwandter sind als 'Katze' und 'Auto'? Die Antwort liegt in einer Technik namens Embeddings, die eine entscheidende Rolle in der Welt der künstlichen Intelligenz und des maschinellen Lernens spielt. In diesem Artikel werden wir uns auf die faszinierende Welt der Embeddings konzentrieren und wie sie die Art und Weise, wie Maschinen Sprache verstehen, revolutionieren.

Wort Embeddings: Eine Einführung

Embeddings sind eine Methode, um Wörter für ein neuronales Netzwerk darzustellen. Sie sind Vektoren, die Wörter repräsentieren, wobei die Nähe der Vektoren die Ähnlichkeit der Wörter, die sie repräsentieren, anzeigt. Diese Methode basiert auf der Annahme, dass Wörter, die in ähnlichen Kontexten verwendet werden, ähnlich sind.

Die Magie von Word2Vec

Ein gutes Beispiel für die Anwendung von Embeddings ist der Word2Vec-Algorithmus. Dieser Algorithmus nutzt die Kraft der Vektorisierung, um die Beziehungen zwischen Wörtern zu erfassen. Er kann zeigen, dass Wörter wie 'Katze' und 'Hund' näher beieinander liegen als 'Katze' und 'Auto'. Aber wie genau macht er das?

Der Word2Vec-Algorithmus analysiert den Kontext jedes Wortes in einem Text.

Er erstellt dann einen mehrdimensionalen Raum, in dem jedes Wort als Vektor dargestellt wird.

Die Position jedes Wortvektors wird durch seine Beziehungen zu anderen Wörtern bestimmt.

Wörter, die in ähnlichen Kontexten verwendet werden, haben nähere Vektoren.

Embeddings und Konzepterfassung

Aber Embeddings können noch mehr! Sie können auch Beziehungen und Konzepte erfassen, wie Geschlecht und geografische Lage. Zum Beispiel kann der Word2Vec-Algorithmus erkennen, dass 'König' zu 'Mann' steht wie 'Königin' zu 'Frau'. Oder dass 'Paris' zu 'Frankreich' steht wie 'Berlin' zu 'Deutschland'. Dies zeigt, dass Embeddings nicht nur die Ähnlichkeit von Wörtern erfassen können, sondern auch ihre Beziehungen und Konzepte.

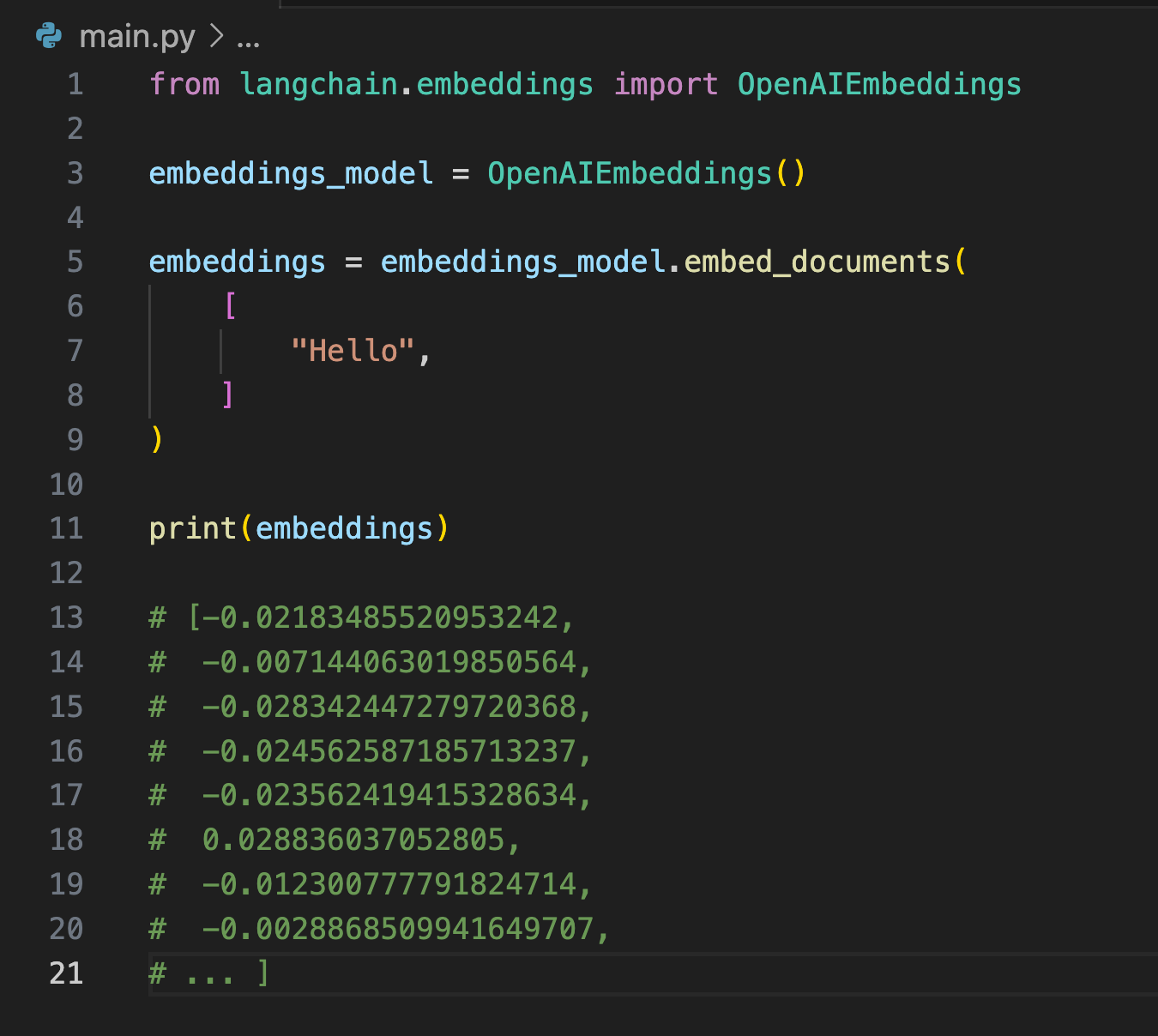

Wie im folgenden Screenshot ersichtlich, wird jedes Wort, wie zum Beispiel „Hello“, mit Embeddings als Vektor aus Fließkommazahlen dargestellt.

FAQs

Was sind Embeddings? Embeddings sind Vektoren, die Wörter repräsentieren. Die Nähe der Vektoren zeigt die Ähnlichkeit der Wörter, die sie repräsentieren.

Wie funktioniert der Word2Vec-Algorithmus? Der Word2Vec-Algorithmus analysiert den Kontext jedes Wortes in einem Text und erstellt dann einen mehrdimensionalen Raum, in dem jedes Wort als Vektor dargestellt wird. Die Position jedes Wortvektors wird durch seine Beziehungen zu anderen Wörtern bestimmt.

Können Embeddings Beziehungen und Konzepte erfassen? Ja, Embeddings können Beziehungen und Konzepte erfassen. Zum Beispiel kann der Word2Vec-Algorithmus erkennen, dass 'König' zu 'Mann' steht wie 'Königin' zu 'Frau'. Oder dass 'Paris' zu 'Frankreich' steht wie 'Berlin' zu 'Deutschland'.

Schlussfolgerung

Embeddings sind ein mächtiges Werkzeug in der Welt der künstlichen Intelligenz und des maschinellen Lernens. Sie ermöglichen es Maschinen, die Ähnlichkeit von Wörtern und die Beziehungen zwischen ihnen zu verstehen. Durch die Anwendung von Algorithmen wie Word2Vec können wir Maschinen beibringen, Sprache auf eine Weise zu verstehen, die der menschlichen sehr ähnlich ist. Und das ist wirklich faszinierend!